Overclocking GPU et optimisation des timings de la mémoire.

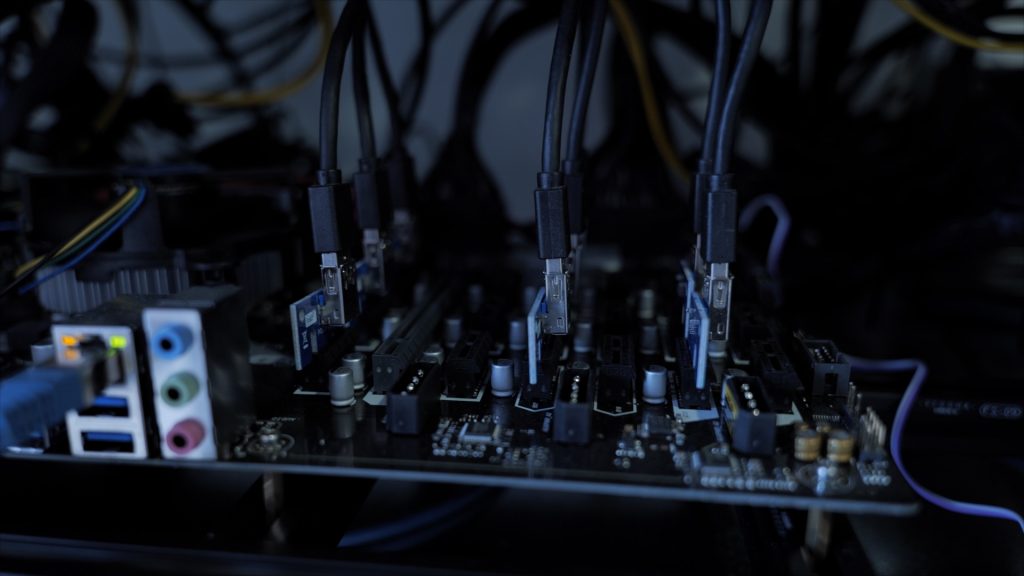

Comme pour les processeurs, les GPU sont souvent issues de chaines de montage identiques, et les dénominations commerciales sont choisies en fonction des résultats des puces aux tests de stabilités. Cependant, l’amélioration des process de fabrication durant la phase de production et l’intérêt de proposer une gamme cohérente avec des produits pour tous les budgets implique que le fabricant intègre dans les gammes inférieures des puces ayant validé des tests plus poussés. Il n’est donc pas rare de pouvoir pousser une puce milieu de gamme à des niveaux équivalents d’un produit plus haut dans la gamme. L’overcloking du GPU est rarement nécessaire pour le mining dans la mesure où, sur les algorithmes les plus populaires, les performances dépendent principalement de la mémoire, de sa vitesse de fonctionnement, mais également des timings :

Les modules de mémoire sur une carte graphique fonctionnent à une vitesse d’horloge donnée mesurée en MegaHerz (MHz) où chaque Herz est un cycle dans lequel la mémoire a le temps de faire des calculs et de travailler. Le chronométrage mesure le retard des puces dans les calculs et fonctionne en interne avant de transmettre les données. Ainsi, même si une puce mémoire fonctionne à des vitesses d’horloge élevées, le travail effectué en interne est limité en raison des retards induits par le minutage de la mémoire. Une puce fonctionnant à 2000 MHz avec des timings lents (retards importants) peut être moins performante qu’une puce fonctionnant à 1500 MHz et des timings rapides (délais courts). Les meilleures performances s’obtiennent donc en modifiant ces timings directement dans le bios de la carte graphique, cela peut être fait grâce au logiciel polaris bios editor par exemple pour les GPU Polaris. La stabilité dépendra alors de la qualité et donc de la capacité de la ram embarquée à supporter ces modifications.

Baisse de la tension pour une meilleure durée de vie

La modification de la tension

La montée en fréquence des composants peut engendrer une consommation électrique accrue nécessaire au bon fonctionnement de la machine.

Abaisser la tension du courant permet de réduire la consommation électrique du GPU et de la mémoire et réduit par conséquent la chaleur dégagée par ceux-ci. Mais Une carte graphique dédiée au mining ne consommera pas autant suivant les algorithmes de hash sur lesquelles elle travaille. Ainsi elle pourra supporter une baisse de tension plus ou moins importante en fonction des monnaies minées. Un réglage optimal des tensions sur un logiciel de minage pour ethereum, ne l’est pas forcément sur cryptonight, et une machine peut être parfaitement stable sur l’un des deux algorithmes (le moins gourmand) et crasher régulièrement sur l’autre ou bien stable sur le plus gourmand, et gaspiller de l’énergie sur l’autre. L’abaissement de la tension ne représente pas de risque pour le matériel, au contraire une consommation moindre réduit la chaleur à dissiper et augmente la longévité des composants. Cependant, un abaissement excessif peut engendrer des crashs de la machine lorsque celle-ci « tire » trop. Il faut donc trouver le bon rapport pour chaque monnaie minée entre consommation électrique, performance et stabilité.

Dissipation thermique et dilatation des circuits.

Si un abaissement de la tension n’est pas directement nocif pour le matériel dans le cas où la machine demeure stable, à l’inverse, une tension trop élevée pour répondre à une consommation excessive de la machine peut endommager plus moins rapidement et de manière irréversible les composants. Une consommation électrique élevée implique une augmentation de la température qui peut à court terme provoquer des nuisances sonores dues au besoin de refroidissement, et des crashs si les composants atteignent malgré tout des températures trop élevées. A long terme, une température moyenne élevée finit par provoquer une dilatation des circuits qui peuvent provoquer des courts-circuits et rendre complètement hors d’usage le matériel.

Selon l’équation d’Arrhenius, le taux de défaillance des semi-conducteurs augmente de manière exponentielle lorsque la température augmente. De 40 °C à 60 °C, le taux de défaillance passe de 10 fois la norme à presque 30 fois. À 80 °C, le taux de défaillance augmente d’un facteur 100 et atteint 300 fois le taux de défaillance normal d’un semi-conducteur. Cette augmentation des taux de défaillance s’explique par les différences de coefficient de dilatation entre le substrat du PCB et l’alliage imprimé servant à conduire le courant. Les machines instables, qui alternent des cycles de surchauffe et de refroidissement rapide lors des crashs, sont plus rapidement sujettes aux courts circuits provoqués par la dilatation des circuits. Il est donc important de chercher à conserver une température au plus bas, quitte à rogner sur les performances.

Privilégier le rapport performance / température à la performance brut.

L’intégration du risque de panne dans le calcul du ROI

Si de prime abord on suppose qu’il sera plus facile d’amortir son matériel rapidement en le poussant dans ses derniers retranchements tant qu’il est stable. Un calcul du ROI classique intègre seulement les couts d’achats et couts variables liés à la mise en route de la machine, mais les risques liés à ce genre de pratique sont trop importants sur la durée pour les composants et l’intégration du risque de panne dans le calcul du ROI se traduise systématiquement par une moins-value. L’allongement de la durée d’amortissement du matériel oblige aujourd’hui à privilégier une machine dont on aura la certitude qu’elle demeurera sans dommage même après 2 ans de fonctionnement. Pour cela et comme expliqué précédemment, il faut chercher à réduire au maximum la température des composants, et cela passe aussi par leur choix et la qualité de l’assemblage.

Le choix des composants.

Pour les cartes graphiques par exemple, chaque constructeur propose différents modèles pour un même GPU. Il ne s’agit pas seulement d’esthétique, les différents modèles proposent non seulement des performances de base différents, soit car les réglages sont différents, soit car les puces mémoires sont de qualités, voire de constructeurs différents, mais également des systèmes de refroidissement aux performances très variable. Utilisation de caloduc en cuivre, backplate, PCB au format élargi pour utiliser des ventilateurs de diamètre supérieur… sont autant d’éléments pouvant améliorer la durée de vie de votre matériel. Chez Btcminers, nous privilégions l’utilisation de modèle haut de gamme, comme la série Aorus de gigabyte par exemple.

La gestion des flux d’air dans le boitier

Afin de conserver les composants au frais, la disposition et la gestion des flux d’air sont primordiales dans le boitier. L’utilisation de rig entièrement ouvert ne permet pas toujours un refroidissement suffisant par manque de brassage et nécessite plus d’entretien (dépoussiérage) particulièrement lorsqu’ils sont posés dans des étagères. Les composants alignés dans les rigs entièrement fermés sous forme de rack bloquent généralement une grande partie du flux d’air, et l’air qui parvient sur les cartes graphiques étant forcément plus chaud que l’air extérieur, il y a donc une perte d’efficacité. Nous pensons que l’idéal est un modèle à plusieurs étages, avec à la base les composants chauffant moins (CPU, CM & SSD) , organisés de façon à rejeter directement l’air chaud à l’extérieur (Alimentation) et un ou plusieurs étages pour les cartes graphiques avec un flux d’air étudié pour ne refroidir que les cartes.

Le choix minutieux et les modifications apportées au matériel sont des étapes indispensables lors de la conception d’une machine et au moins aussi importantes que sa puissance brute afin d’obtenir un retour sur investissement positif à long terme.